Des premières données chiffrées ont été dévoilées par les éditeurs d'outils d'intelligence artificielle. Un premier pas vers plus de transparence sur les impacts environnementaux de l'IA générative, mais encore insuffisant.

Ils ont été les premiers à jouer la carte de la transparence. En juillet dernier, Mistral AI a dévoilé l'impact environnemental de son modèle d'intelligence artificielle Large 2. Ils ont été rapidement suivis par Google qui a dévoilé à son tour l'impact environnemental de son modèle Gemini. Vous pouvez retrouver le détail du bilan de Mistral AI dans cette publication, et celui du bilan de Google dans cette publication en anglais. Nous revenons dans cet article sur les résultats affichés par les deux bilans, sur les différences dans les approches des deux entreprises, ainsi que sur les limites des études réalisées.

Bilan environnemental : Mistral AI et Google Gemini

Les résultats affichés par les deux entreprises sont significativement différents, et le périmètre étudié l'est également. Mistral AI a réalisé une analyse du cycle de vie de modèle d'IA, de la conception du modèle à son utilisation, en passant par son entrainement. Google a, de son coté, uniquement présenté le bilan du prompt (une utilisation) de Gemini.

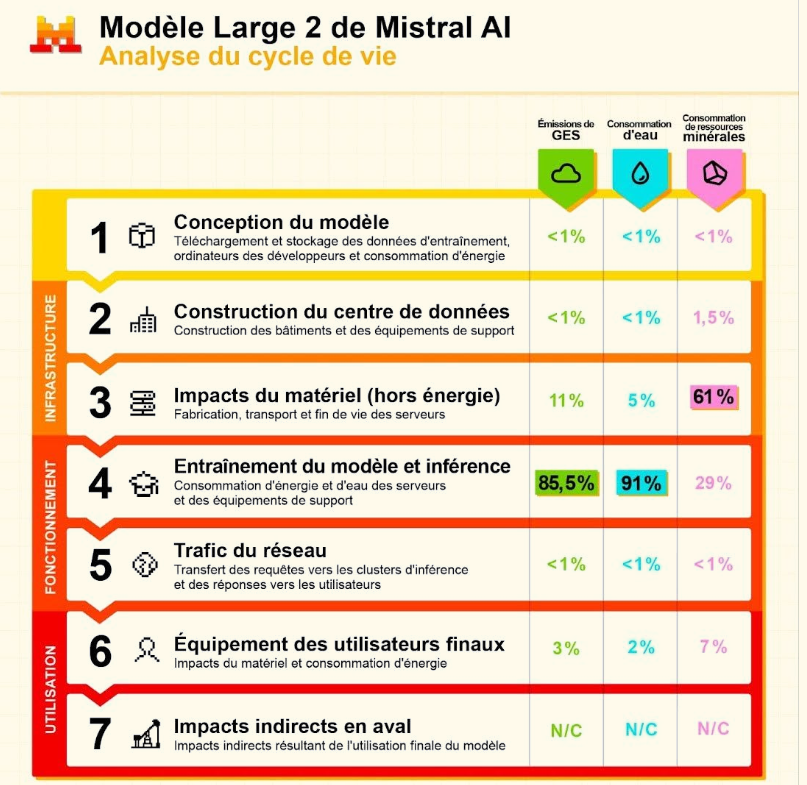

Concernant Mistral AI, la partie développement a donc entrainé les impacts suivants :

- 20400 tonnes de CO2 eq,

- 281 000 m3 d'eau consommée, et

- 660 kg Sb eq (Cet indicateur d'impacts est exprimé en kg équivalent antimoine (kg éq Sb). Il représente l'extraction de minéraux et de carburants fossiles en fonction des réserves disponibles et de leur consommation actuelle.).

L'essentiel des émissions de gaz à effet de serre (86%) et de consommation d'eau (91%) réside dans la phase d'entrainement, tandis que la consommation de ressources est en majorité (61%) liée à l'impact du matériel (fabrication, transport et fin de vie des serveurs).

Concernant la phase d'utilisation, chaque bilan nous apporte les impacts marginaux de l'utilisation : la génération d'une page de texte générée (400 tokens) côté Mistral AI, un prompt médian coté Google, qui n'indique ni la taille du prompt ni le nombre de tokens utilisés.

Les impacts marginaux affichés sont les suivants :

Mistral AI Large 2

- 1.14 g CO2eq

- 45 ml d'eau

Google Gemini

- 0.03g C02eq

- 0.26ml d'eau

Google présente ainsi des émissions de CO2eq 38 fois inférieurs à Mistral AI, et une consommation d'eau 173 fois inférieures.

Par ailleurs, on notera qu'aucune des deux entreprises ne partage d'informations sur le volume de requêtes qui permettrait de remettre en perspective cet impact marginal. Ainsi on nous indique du côté de Google que les émissions de gaz à effet de serre auraient été divisées par 44 pour chaque utilisation. Mais dans le même temps, on découvrait dans le bilan environnemental 2025 de Google que les émissions globales de l'entreprise avaient augmenté de 11% en un an et de 51% depuis 2019, notamment en lien avec le développement de l'IA. Il semblerait bien que nous soyons face à un cas typique d'effet rebond.

Les différences entre les deux approches

Comme nous le disions précédemment, Mistral AI a basé son travail sur une analyse du cycle de vie de son modèle, en collaboration avec le cabinet Carbone 4 et l'Ademe. L'étude a été revue par deux autres cabinets spécialisées dans les analyses du cycle de vie dans le secteur numérique, Resilio et Hubblo.

De son côté, Google a réalisé une étude en interne, non soumis à une relecture scientifique. L'utilisation d'un prompt médian et non d'un prompt moyen, sans précision sur la taille de celui-ci, est également un point qui limite grandement la transparence des résultats affichés par Google, et la comparabilité à d'autres résultats, comme ceux de Mistral AI.

Les limites des études réalisées

En l'état actuel, nous voyons que les résultats de ces études sont difficilement comparables. Aussi, en l'absence d'informations partagées sur le volume de requêtes traitées et en ne parlant que de l'impact marginal, les acteurs de l'IA tendent à minimiser l'impact de leur modèle, en omettant ainsi sciemment le problème de l'effet rebond.

On saluera l'effort de transparence de Mistral AI, qui ne s'est pas contenté de partager les impacts d'un prompt, mais on déplore globalement l'absence de partage du détail de la méthodologie, et l'absence d'accès à des données brutes qui permettraient à la communauté scientifique de travailler sur le sujet.

Ces différentes publications mettent en exergue le besoin d'une méthodologie commune approuvée par la communauté scientifique et reconnue au niveau international.